こんにちは、にしくんです。

今回はScratchを使ってAIの土台となる技術について夏休みの実験をしていきたいと思います!

突然ですがみなさんは機械学習という言葉を耳にしたことはあるでしょうか?

最近では車やロボットの自動運転や日常生活の補助をしてくれるバーチャルアシスタント、写真や動画をかわいく盛って楽しむことができる加工アプリなどのAIを使ったサービスがより身近な物になっているのを感じますよね。

実はこれらのサービスのAIの作成において「機械学習」というものが大きく関わっているのですが

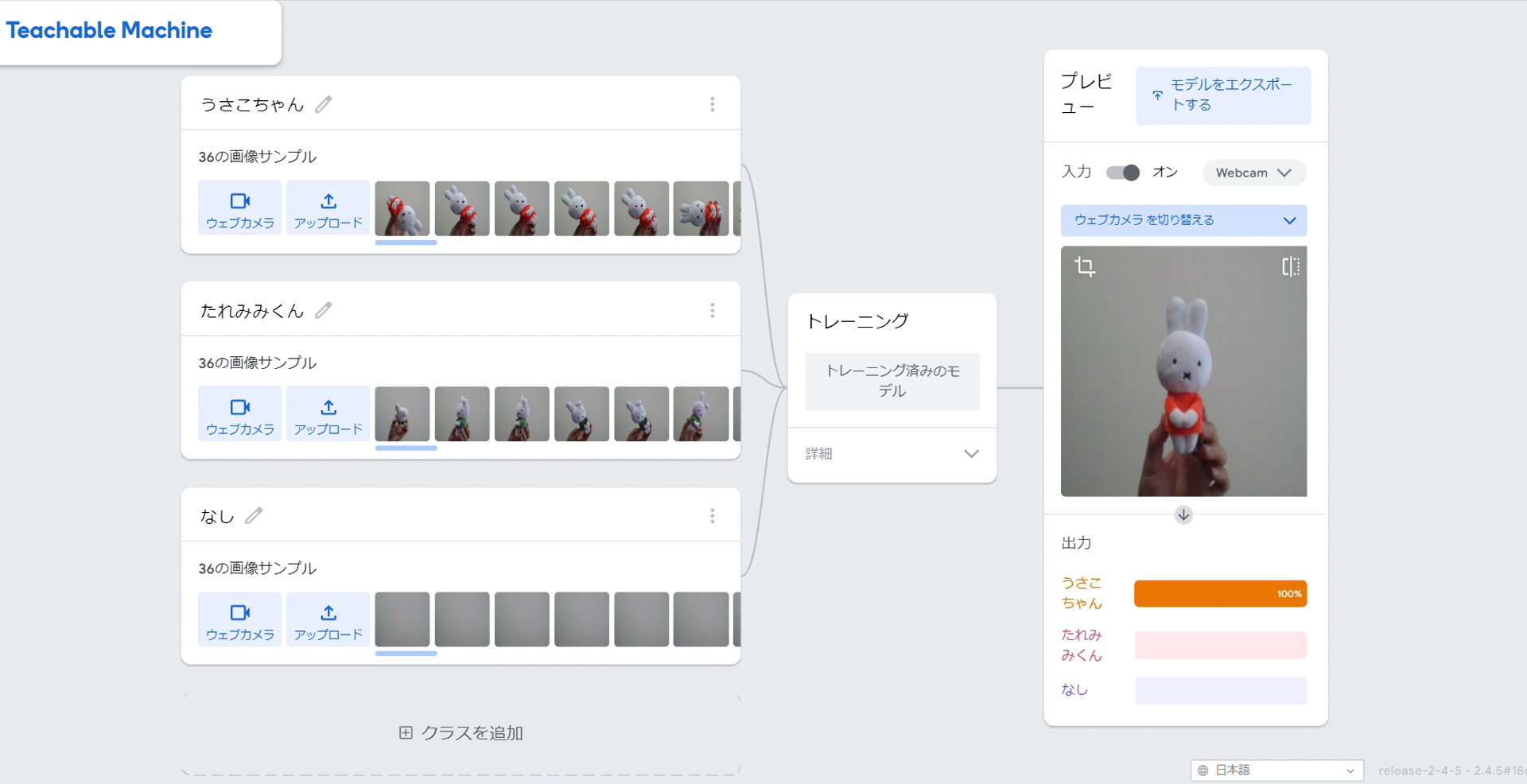

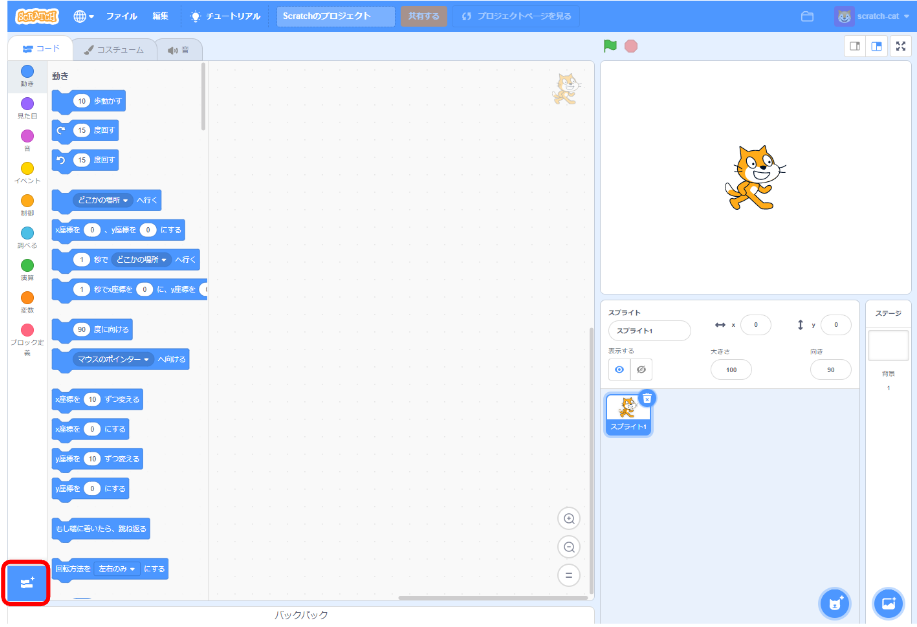

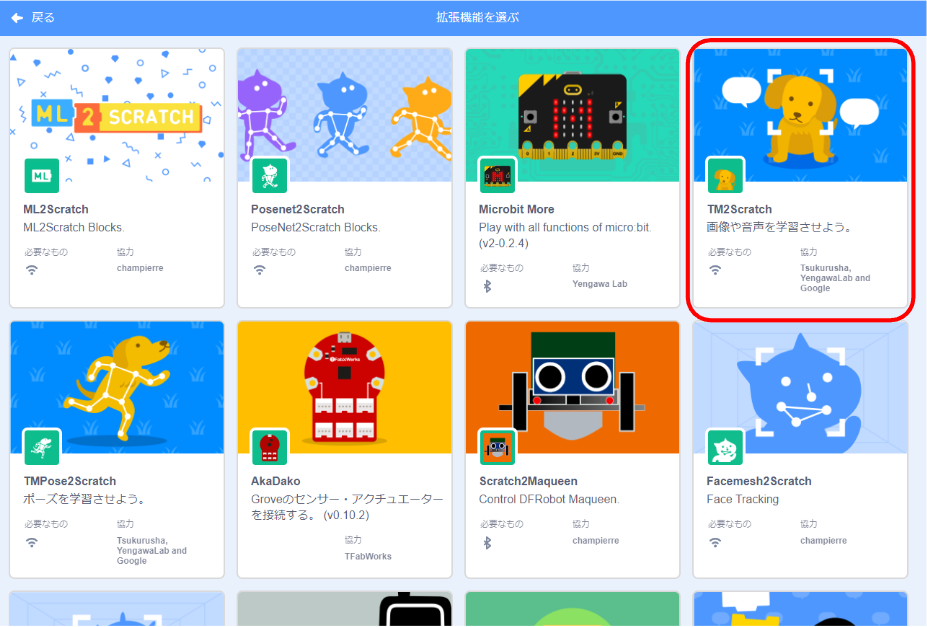

実際どのような仕組みで動いているのでしょうか。試していきましょう!